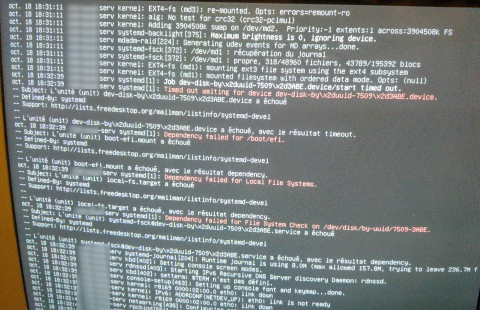

J'ai eu quelques mésaventures avec un raid1 mdadm sous debian 8, je vous explique.

J'ai un disque qui est tombé en panne, évidemment le disque en panne contenait le grub et j'avais oublié par mégarde lors de l'installation, d'installer grub sur le second disque.

Voici ce que j'ai fait :

1- La machine est actuellement démarrée et ne peux plus être arrêtée... sinon elle ne redémarrera pas.

2- J'ai pu déconnecter le disque défectueux de 2 arrays sur 3 via la commande mdadm --manage --remove

3- Impossible de déconnecter du raid l'array md1 qui contient /boot

4- J'ai réinséré le disque neuf et j'ai synchronisé les deux arrays.

J'ai donc aujourd'hui deux problèmes :

Comment synchroniser l'array qui contient /boot ? :

Code : Tout sélectionner

serv:~# cat /proc/mdstat

Personalities : [raid1]

md3 : active raid1 sde4[2] sdb4[1]

972431360 blocks super 1.2 [2/2] [UU]

bitmap: 2/8 pages [8KB], 65536KB chunk

md2 : active raid1 sde3[2] sdb3[1]

3904512 blocks super 1.2 [2/2] [UU]

md1 : active raid1 sda2[0](F) sdb2[1]

195392 blocks super 1.2 [2/1] [_U]

unused devices: <none>

Code : Tout sélectionner

serv:~# mdadm --manage /dev/md1 --remove /dev/sda2 --force

mdadm: Cannot find /dev/sda2: No such file or directory

Code : Tout sélectionner

# mdadm --manage /dev/md1 --add /dev/sde2

mdadm: /dev/md1 has failed so using --add cannot work and might destroy

mdadm: data on /dev/sde2. You should stop the array and re-assemble it.

Comment réinstaller le grub sur la partition EFI ?

Code : Tout sélectionner

# update-grub

Création du fichier de configuration GRUB…

/usr/sbin/grub-probe : attention : Impossible de trouver le volume physique « (null) ». Certains modules risquent de manquer dans l'image de base..

/usr/sbin/grub-probe : attention : Impossible de trouver le volume physique « (null) ». Certains modules risquent de manquer dans l'image de base..

/usr/sbin/grub-probe : attention : Impossible de trouver le volume physique « (null) ». Certains modules risquent de manquer dans l'image de base..

/usr/sbin/grub-probe : attention : Impossible de trouver le volume physique « (null) ». Certains modules risquent de manquer dans l'image de base..

Image Linux trouvée : /boot/vmlinuz-3.16.0-4-amd64

Image mémoire initiale trouvée : /boot/initrd.img-3.16.0-4-amd64

/usr/sbin/grub-probe : erreur : disque « mduuid/6ea0bc18e0759f71a1da3b3a2ce30602 » non disponible.

/usr/sbin/grub-probe : erreur : disque « mduuid/6ea0bc18e0759f71a1da3b3a2ce30602 » non disponible.

/usr/sbin/grub-probe : erreur : disque « mduuid/6ea0bc18e0759f71a1da3b3a2ce30602 » non disponible.

/usr/sbin/grub-probe : attention : Impossible de trouver le volume physique « (null) ». Certains modules risquent de manquer dans l'image de base..

Code : Tout sélectionner

serv:~# grub-install /dev/sdb

Installing for x86_64-efi platform.

grub-install : erreur : impossible de trouver le répertoire EFI.

serv:~# grub-install /dev/sde

Installing for x86_64-efi platform.

grub-install : erreur : impossible de trouver le répertoire EFI.

INFOS COMPLEMENTAIRES :

Code : Tout sélectionner

# <file system> <mount point> <type> <options> <dump> <pass>

# / was on /dev/md3 during installation

UUID=782028b0-9d22-42a9-8be0-ba92ee475fa5 / ext4 errors=remount-ro 0 1

# /boot was on /dev/md1 during installation

UUID=29d5bd4d-1c1c-43fa-b85f-3a573b043ed0 /boot ext3 defaults 0 2

# /boot/efi was on /dev/sda1 during installation

UUID=7509-3ABE /boot/efi vfat umask=0077 0 1

# swap was on /dev/md2 during installation

UUID=6aa22672-3501-4739-8017-f37fa8b7ca5f none swap sw 0 0

Code : Tout sélectionner

serv:~# mdadm --detail /dev/md1

/dev/md1:

Version : 1.2

Creation Time : Sun Mar 20 11:12:07 2016

Raid Level : raid1

Array Size : 195392 (190.84 MiB 200.08 MB)

Used Dev Size : 195392 (190.84 MiB 200.08 MB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Mon Oct 17 16:17:44 2016

State : clean, degraded

Active Devices : 1

Working Devices : 1

Failed Devices : 1

Spare Devices : 0

Name : serv:1 (local to host serv)

UUID : 6ea0bc18:e0759f71:a1da3b3a:2ce30602

Events : 88

Number Major Minor RaidDevice State

0 0 0 0 removed

1 8 18 1 active sync /dev/sdb2

0 8 2 - faulty

Code : Tout sélectionner

serv:~# mdadm --detail /dev/md2

/dev/md2:

Version : 1.2

Creation Time : Sun Mar 20 11:12:19 2016

Raid Level : raid1

Array Size : 3904512 (3.72 GiB 4.00 GB)

Used Dev Size : 3904512 (3.72 GiB 4.00 GB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Mon Oct 17 16:00:28 2016

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Name : serv:2 (local to host serv)

UUID : 6bfbb645:75b97328:f567a7e0:9b438d21

Events : 158

Number Major Minor RaidDevice State

2 8 67 0 active sync /dev/sde3

1 8 19 1 active sync /dev/sdb3

Code : Tout sélectionner

root@serv:~# mdadm --detail /dev/md3

/dev/md3:

Version : 1.2

Creation Time : Sun Mar 20 11:12:30 2016

Raid Level : raid1

Array Size : 972431360 (927.38 GiB 995.77 GB)

Used Dev Size : 972431360 (927.38 GiB 995.77 GB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Intent Bitmap : Internal

Update Time : Mon Oct 17 19:08:11 2016

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Name : serv:3 (local to host serv)

UUID : ae05dd4c:d03bfb24:2b45ef0b:f2c47890

Events : 212915

Number Major Minor RaidDevice State

2 8 68 0 active sync /dev/sde4

1 8 20 1 active sync /dev/sdb4